Im Rahmen meines laufenden Forschungsprojekts habe ich versuche, photogrammetrische Modelle verschiedener Dinosaurier zu erstellen, unter anderem auch von den MfN Sauropoden. Das ist aus verschiedenen Gründen ein ziemliches Gefriemel.

Erstens ist Photogrammetrie einfach nicht gut für Rippenkörbe geeignet, weil eine ganze Reihe von Flächen – Innenseiten von Rippen und die Wirbelcenta – innen liegen, daher schlecht beleuchtet sind, und in den Modellen nur schlecht dargestellt werden. Schlechte Beleuchtung bedeutet, dass weniger Punkte gefunden werden, und das führt zu großen Löchern. Noch dazu entsteht immer eine Menge frei flotierender Unsinn an Punkten.

Zweitens füllt die ganze Architektur im Hintergrund eines großen Objekts, um das man bei Fotografieren herum gehen muss, große Flächen auf den Fotos. Repetitive Flächen, die zu vielen falsch zugeordneten Punkten führen. Daraus resultiert dann eine falsche Ausrichtung der Fotopositionen.

Drittens werden die Knochen immer mit Strahlern beleuchtet, sind teils also sehr hell und teils von Schlagschatten verdunkelt. Das ist dann die Garantie für Löcher im Modell. Und für flotierende Unsinnsdaten, zum Beispiel zwischen den Rippen.

Daher waren meine Versuche, gute Modelle ganzer Skelettmontagen oder auch einzelner montierter Knochen zu erstellen ein ganz klein wenig schwieriger als geplant. Viel schwieriger im Falle des Diplodocus des MfN, eines Abguss des Carnegie-Diplodocus, in mittlerem Dunkelbraun angemalt. Ich unternahm einen Versuch, ein Modell des Schultergürtels zu rechnen und schaffte immer nur ein Alignment der Fotos bei dem eine flache 2D-Fläche herauskam, aus Sicht von vorne unten – im Grund, wie ein Foto das man von einer Position unter dem Kopf aufnimmt. AARGH!!!

Vor kurzem kam dann die pre-release 1.0 Version meiner Photogrammetrie-Software raus. Zuvor hatte ich 0.9 von Agisoft Photoscan Professional genutzt, und war eigentlich sehr glücklich damit. Aber die 1.0er hat eine Menge interessantes neues zu bieten. Ein Schlüsselfunktion ist nun die Möglichkeit, eine dichte Punktwolke zu berechnen und Zugang zu ihr zu haben. Zuvor berechnete Photoscan zwar eine solche, baute aber sofort aus ihr ein Polygonnetz. Die dichte Punktwolke war für den Nutzer nicht zugänglich.

Für die meisten Schritte der Weiterbearbeitung reicht die dichte Punktwolke vollkommen aus: Müll wegschneiden, zuschneiden, und so weiter. Und sie handhabt sich sehr viel schneller als das Polygonnetz. Und außerdem mesht Photoscan zwar recht gut, aber ich habe Software zur Verfügung, die das noch besser kann. Daher ist es eine tolle Neuigkeit, dass ich jetzt die dichte Punktwolke in meine digitalen Pfoten bekomme.

“Moment mal, was ist denn eine dichte Punktwolke?” fragt ihr?

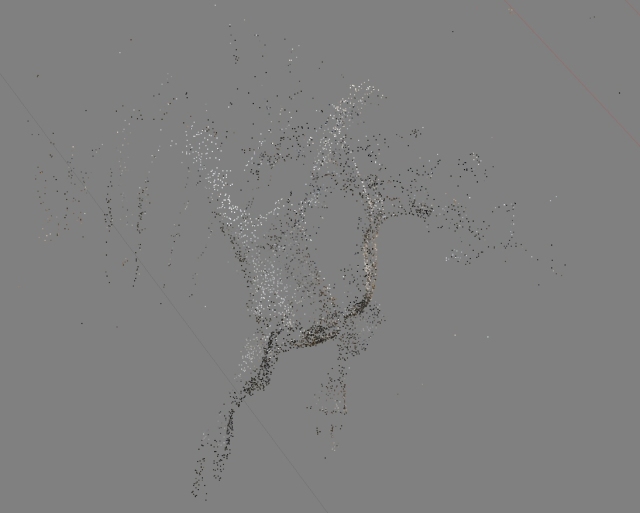

Nun, genau wonach es klingt: eine Punktwolke in der die Abstände zwischen den Punkten sehr klein sind. Wenn man ein Modell aus Fotos errechnet, muss man erst die Bilder korrekt ausrichten: das Programm findet heraus, wo die Kamera bei der Aufnahme welches Bildes war, und wohin sie zeigte. Das geschieht, indem Punkte von verschiedenen Fotos einander zugeordnet werden, aber es braucht dafür nicht viele Punkte. Diese stellen die dünnbesetzte (englisch “sparse”) Punktwolke dar. Diese hat meist genug Punkte, um einem zu erlauben, die Qualität der Fotoausrichtung einzuschätzen – OK oder kompletter Blödsinn? Im nächsten Schritt wird dann eine dichte Punktwolke, um eine größtmögliche Annäherung an der echte Objekt zu erhalten. Unten mal ein Screenshot einer dünnbesetzten Punktwolke und der dichten, die aus ihr errechnet wurde (mittlere Dichte in Photoscan).

Dieses Modell ist ganz offensichtlich im Pre-release von Photoscan gerechnet, sonst könnt eich ja keine dichte Punktwolke zeigen. Und es sieht gut aus – viel besser als das, was ich oben beschrieben habe. Das liegt zum Großteil an Verbesserungen in Photoscan.

Aber es kommt noch etwas hinzu. Ich nutze eine Canon EOS 650D, und die hat einen Programmmodus für HDR Bilder. Sie macht drei Aufnahmen schnell hintereinander, mit verschiedenen ISO-Werten, und berechnet daraus ein Bild. Im Gegensatz zu HDR-Aufnahmen, die man selbst nachträglich in einem anderen Programm errechnet, haben diese Bilder volle EXIF-Daten, was sie Photoscan-tauglich macht. Obwohl sie oft nicht perfekt scharf sind (ja, auch mit Stativ nicht), haben sie doch den großen Vorteil dass die Schatten weniger dunkel und die Highlights weniger überstrahlt sind. Und das ist ein ganz wichtiges Ding für Phptogrammetrie. Ich habe mal meine alten Fotos durch das 1.0er Photoscan gejagt, und das ging tatsächlich viel besser als früher (d.h., es kam 3D statt 2D-Qaurk raus). Aber das Modell hatte viel weniger gute Oberflächen als mit den HDR-Bildern. Die rechte Scapula und die Rippen waren gut, aber links:

und mit HDR:

Ein ganz schöner Unterschied!

Also habe ich noch mehr mit HDR-Bildern rumgespielt:

Unterschenkel von Diplodocus, dichte Punktwolke.

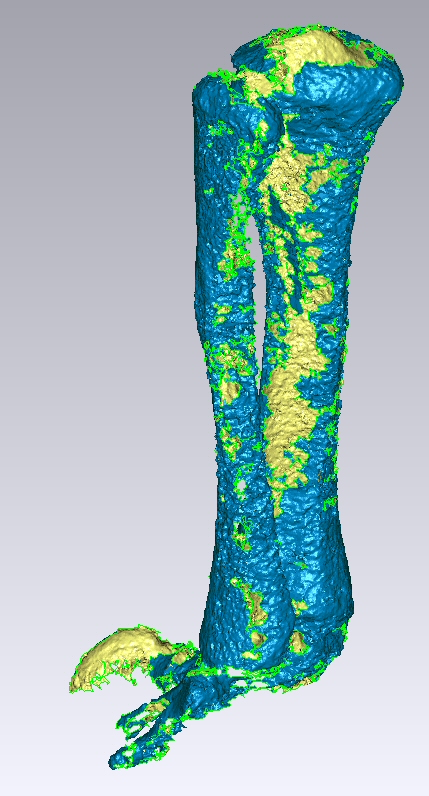

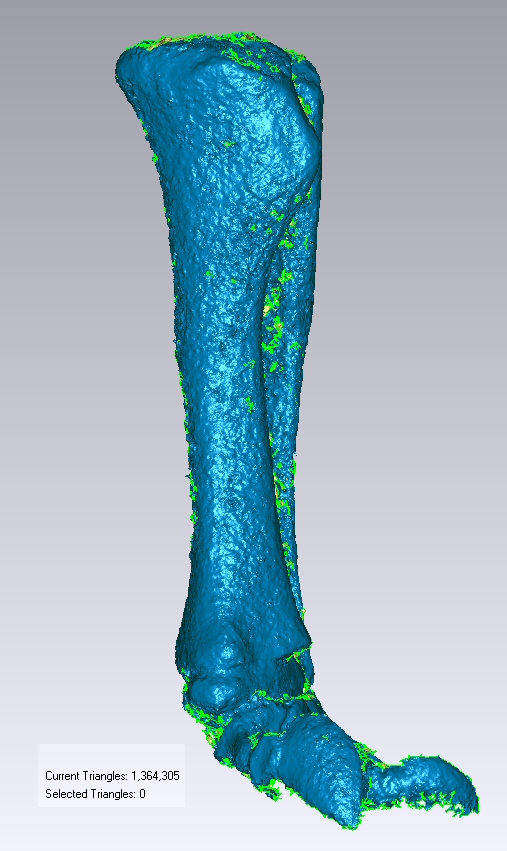

andere Seite. Das Modell siht auf der Innenseite (Tibia-Seite) richtig gut aus, aber auf der fibularen Seite nicht ganz so. Das merkt man auch nach dem Vermaschen in Geomagic:

Dennoch – diese 3D-Modelle kann ich zügig in etwas editieren, das gut genug für SIMM-Modellierungen ist! Ich liebe es 🙂